I dispositivi e le applicazioni software che utilizzano l’Intelligenza Artificiale, stanno diventando sempre più numerosi. Essa viene utilizzata in innumerevoli settori, ed è oramai entrata a far parte della nostra vita quotidiana, nelle nostre case, nei luoghi di lavoro e nell’ecosistema sociale

Uno dei maggiori vantaggi della Intelligenza Artificiale risiede nella sua capacità di apprendere dall’uso e dall’esperienza reale migliorando di continuo le sue prestazioni.

Anche nel mondo medicale e dei dispositivi medici, in particolar modo quelli classificabili come SaMD (Software as Medical Device), i prodotti realizzati e governati attraverso l’IA stanno trasformando le modalità di gestione dell’assistenza sanitaria grazie alla loro capacità di elaborazione di una gran quantità di dati generati ogni giorno, che rendono tale tecnologia indispensabile per

- Identificare malattie

- Classificare ed analizzare i dati in una epidemia

- Ottimizzare una terapia medica

- Effettuare un supporto diagnostico

COSA SI INTENDE PER INTELLIGENZA ARTIFICIALE

L’Intelligenza Artificiale è stata definita come la scienza che viene applicata per realizzare macchine intelligenti, in particolare attraverso programmi per computer : é l’abilità di una macchina o di una applicazione di mostrare capacità umane quali il ragionamento, l’apprendimento, la pianificazione e la creatività.

Ha come scopi principali quelli di capire il proprio ambiente, mettersi in relazione con quello che percepisce, risolvere problemi e agire verso un obiettivo specifico: il computer riceve dei dati li processa e agisce di conseguenza

Sotto la definizione di Intelligenza Artificiale vi sono diverse tecnologie che hanno modalità di applicazione diverse. Ad esempio le più diffuse sono:

- Machine Learning (apprendimento automatico): che è un metodo di Analisi dei dati che automatizza la costruzione di un modello analitico. È basata sull’idea che i Sistemi di IA possono imparare dai dati, identificare i modelli e prendere decisioni con un minimo di intervento umano: si addestra la macchina su come imparare

- Expert System : sono programmi che cercano di riprodurre le prestazioni di una o più persone esperte in un determinato campo di attività. Sono in grado di porre in atto procedure adeguate alla risoluzione di problemi particolarmente complessi, sui quali potrebbe intervenire solo un esperto del settore disciplinare in cui rientra la questione da risolvere.

- Reti Neurali : sono sistemi hardware e/o software sviluppati ispirandosi al funzionamento delle reti neurali biologiche presenti nel cervello umano e in grado di produrre il ragionamento. È costituita da un ampio numero di unità elaborative, altamente interconnesse, strutturate su più livelli e operanti in parallelo.

- Deep Learning : è una tipologia di Machine Learning dove si utilizzano le Reti Neurali. Opera sfruttando differenti classi di algoritmi disposti su più livelli in cascata, dove ogni livello effettua trasformazioni ed estrazioni basate su caratteristiche specifiche usando come input il risultato del livello precedente.

RISCHI CONNESSI CON UN SISTEMA DI IA

Con lo sviluppo della Intelligenza Artificiale in numerosi campi di applicazione, si porrà sempre di più il problema etico del nostro rapporto con le macchine e con le applicazioni che le utilizzano

Da un lato è quindi necessario assicurarsi che le IA non siano dannose per gli esseri umani, dall’altro è importante riflettere su quanto sia morale l’utilizzo di tali macchine.

Un Sistema di IA è costruito per raggiungere un determinato obiettivo e potrà capitare che, nel tentativo di portare a termine il compito assegnato, tale sistema si trovi davanti alla necessità di effettuare delle scelte: per avere la sicurezza che non commetta degli errori, chi lo programma dovrà prendere in considerazioni tutte le possibili implicazioni di tali scelte in un dato contesto e così prevedere possibili casi in cui il sistema stesso potrebbe comportarsi in modo sbagliato dal punto di vista etico

Il più semplice degli esempi è quello delle automobili che si guidano da sole: cosa faranno quando dovranno decidere se investire una scolaresca o evitarla schiantandosi su un muro con gravi conseguenze per i passeggeri?

A maggior ragione il problema etico della Intelligenza Artificiale si pone in ambito medico dove i fruitori di tali sistemi non sono solo dei semplici utenti, ma soprattutto dei pazienti per i quali dalle decisioni prese da un Sistemi di AI dipende la loro salute

In quest’ambito il Comitato Nazionale per la Bioetica ha espresso alcuni pareri sull’utilizzo dell’IA nel campo della salute raccolti in un documento del maggio 2020 dove si sottolinea le opportunità, i rischi e le principali applicazioni dell’IA in medicina, dedicando particolare attenzione agli aspetti etici.

PRINCIPI ETICI DI UN SISTEMA DI IA

Per rispondere a questo tipo di esigenza, la Commissione Europea ha diffuso un contributo “Orientamenti Etici per un AI affidabile” all’interno del quale ci si pone il problema delle possibili controindicazioni che possono insorgere nello sviluppo di sistemi di IA.

In particolare sono stati identificati quattro principi etici, radicati nei diritti fondamentali dell’uomo, ai quali occorre aderire per garantire che i sistemi di IA siano sviluppati, distribuiti e utilizzati in modo affidabile.

- rispetto dell’autonomia umana: che significa che gli esseri umani che interagiscono con i sistemi di IA devono poter mantenere la propria piena ed effettiva autodeterminazione. I sistemi di IA non devono quindi subordinare, costringere, ingannare, manipolare, condizionare o aggregare in modo ingiustificato gli esseri umani

- prevenzione dei danni: che significa che I sistemi di IA non devono causare danni, né aggravarli e neppure influenzare negativamente gli esseri umani, per i quali occorre tutelare la dignità umana nonché l’integrità fisica e psichica. I sistemi di IA e gli ambienti in cui operano devono essere sicuri e protetti. Devono essere tecnicamente robusti e si deve garantire che non siano esposti ad usi malevoli

- equità : che implica un impegno a garantire una distribuzione giusta ed equa di costi e di benefici; che l’utilizzo dei sistemi di IA non deve mai ingannare gli utenti né ostacolarne la libertà di scelta; che gli operatori del settore dell’IA rispettino il principio di proporzionalità tra mezzi e fini, e valutino attentamente come bilanciare interessi e obiettivi concorrenti

- esplicabilità : che implica che i processi governati dalla IA devono essere trasparenti.

Le capacità e lo scopo di un Sistema di IA deve essere comunicato apertamente e le decisioni, per quanto possibile, devono poter essere spiegate a coloro che ne sono direttamente o indirettamente interessati

Partendo dunque da questi principi, allo scopo di ottenere Sistemi di IA affidabili, sono stati individuati tre componenti principali che sono stati sviluppati in 7 requisiti che a loro volta sono declinati in una serie di sotto-requisiti che hanno l’obiettivo di mettere in pratica tali requisiti durante l’intero ciclo di vita di un sistema basato sulla IA

Tali componenti sono:

- legalità, l’IA deve ottemperare a tutte le leggi e ai regolamenti applicabili;

- eticità, l’IA deve assicurare l’adesione a principi e valori etici

- robustezza, dal punto di vista tecnico e sociale allo scopo di evitare che l’ AI non causi danni anche non intenzionali.

Ciascuna componente in sé è necessaria ma non sufficiente per realizzare un’IA affidabile. Idealmente le tre componenti dovrebbero operare armonicamente ed essere sovrapponibili.

REQUISITI DI AFFIDABILITÀ DI UN SISTEMA DI IA

Nel documento Orientamenti Etici per un AI affidabile, tali principi sono stati dettagliati in 7 requisiti e in un certo numero di sotto requisiti, soddisfatti i quali, si è in grado di affermare che un’applicazione software basata sulla IA si può considerare affidabile. Tali requisiti sono:

1) Supervisione umana:

Collegato al principio di Rispetto dell’autonomia Umana. E’ fondamentale che il sistema di IA sia sempre sorvegliato da personale umano, a garanzia del rispetto dei diritti fondamentali e del benessere dell’utente. In particolare questo requisito si esplica in sotto requisiti quali:

-

- Salvaguardia dei Diritti fondamentali :da valutare, attraverso una valutazione di Impatto, se il Sistema IA violi alcuni diritti fondamentali (es. la riservatezza dei Dati personali).

- Possibilità di Intervento Umano: gli utenti dovrebbero ricevere le conoscenze e gli strumenti per comprendere e interagire con il Sistema di IA ad un livello soddisfacente.

- Sorveglianza Umana : per garantire che un Sistema di IA non comprometta l’autonomia umana o provochi altri effetti negativi. Tale sorveglianza può esplicitarsi attraverso meccanismi di governance del sistema che consentono un approccio con intervento umano.

2) Robustezza e Sicurezza:

Collegato al principio di Prevenzione dei Danni . E’ necessario che il Sistema di IA sia sviluppato con un approccio di prevenzione dei rischi e in maniera tale che si comporti in modo attendibile e secondo quanto previsto, riducendo al minimo i danni non intenzionali e imprevisti e prevenendo danni inaccettabili. In particolare questo requisito si esplica in sotto requisiti quali:

-

- Resilienza agli attacchi e Sicurezza : Il Sistema di IA, come tutti i sistemi software, dovrebbero essere protetti contro le vulnerabilità nei confronti della sicurezza delle informazioni e da potenziali abusi. Eventuali attacchi possono modificare il comportamento del sistema, il quale può essere indotto ad adottare decisioni diverse da quelle attese

- Piano di emergenza : al fine di garantire che il Sistema di IA svolga il compito assegnato senza danneggiare gli esseri viventi o l’ambiente dovrebbero essere adottati misure di salvaguardia che, sulla base dei rischi individuati, attivino un piano di emergenza in caso di problemi

- Precisione: è necessario che un Sistema di IA produca risultati con un alto livello di precisione soprattutto quando le attività di tale sistema influiscono direttamente sulle vite umane: é importante che il sistema sia anche in grado di indicare la probabilità di errore

- Affidabilità e riproducibilità : Un sistema IA è affidabile se funziona correttamente con una serie di input e in varie situazioni e mostra lo stesso comportamento quando ripetuto nelle stesse condizioni

3) Riservatezza e governance dei dati:

Collegato al principio di Prevenzione dei Danni. Per prevenire danni alla riservatezza occorre tra l’altro un’adeguata governance dei dati che riguardi la qualità e l’integrità dei dati utilizzati, la loro pertinenza rispetto al settore in cui i sistemi di IA saranno distribuiti, i protocolli di accesso e la capacità di trattare i dati in modo da tutelare la riservatezza. In particolare questo requisito si esplica in sotto requisiti quali:

-

- Riservatezza e protezione dei dati : Il Sistema di IA deve garantire la riservatezza e la protezione dei dati durante il suo intero ciclo di vita, comprese le informazioni fornite inizialmente dall’utente e quelle generate nel corso della sua interazione con il sistema

- Qualità ed Integrità dei dati : I dati che vengono raccolti, possono contenere distorsioni, imprecisioni, errori, ed è un aspetto da affrontare prima di addestrare il Sistema di IA con un determinato insieme di dati. Se si immettono dati malevoli, un Sistema di IA può cambiare il suo comportamento, in particolare con i sistemi di autoapprendimento

- Accesso ai dati : in ogni organizzazione che gestisce i dati personali (che si tratti o meno di un utente del sistema), dovrebbero essere messi in atto protocolli che ne regolino l’accesso

4) Trasparenza:

Collegato al principio della Esplicabilità. Comprende la trasparenza degli elementi pertinenti per un Sistema di IA: i dati, il sistema e i modelli. In particolare questo requisito si esplica in sotto requisiti quali:

-

- Tracciabilità: l’insieme dei dati, dei processi e degli algoritmi utilizzati che determinano le decisione del Sistema di IA, dovrebbero essere documentati per consentire la tracciabilità e aumentare la trasparenza

- Spiegabilità : se un sistema di IA influisce considerevolmente sulla vita delle persone, dovrebbe sempre essere possibile richiedere una spiegazione adeguata del processo decisionale del sistema stesso

- Comunicazione : i sistemi di IA non devono presentarsi agli utenti come esseri umani e gli esseri umani hanno il diritto di essere a conoscenza del fatto che stanno interagendo con un Sistema di IA. Tale conoscenza dovrebbe comprendere la comunicazione del livello di precisione del sistema di IA e dei suoi limiti

5) Diversità e non discriminazione:

Collegato al principio della Equità. Il Sistema di IA dovrebbe tenere conto delle diverse e distinte abilità e capacità umane, garantendo al tempo stesso a tutti il libero accesso a tale strumento. In particolare questo requisito si esplica in sotto requisiti quali:

-

- Evitare distorsioni inique : l’insieme dei dati utilizzati dal Sistema di IA (sia per l’addestramento che per il funzionamento) ed il modo in cui viene sviluppato possono subire l’influenza di distorsioni non intenzionali, dovute a situazioni di incompletezza e di modelli di cattiva governance del sistema. La soluzione a tal riguardo potrebbe risiedere nell’attuazione di processi di sorveglianza per analizzare e affrontare in modo chiaro e trasparente le finalità, i vincoli, i requisiti e le decisioni del sistema

- Accessibilità alla tecnologia : Il Sistema di IA dovrebbe essere progettato in modo che tutte le persone possano utilizzare il Sistema di IA, indipendentemente dall’età, dal genere, dalle abilità o dalle caratteristiche personali con particolare riguardo per le persone con disabilità

- Partecipazione attiva degli Stakeholders : al fine di sviluppare il Sistemi di IA in modo affidabile, è consigliabile consultare i portatori di interessi che possono essere direttamente o indirettamente interessati dal sistema durante l’intero ciclo di vita di quest’ultimo

6) Benessere sociale e ambientale:

Collegato ai principi di Equità e di Prevenzione dei danni. E’ necessario avere sempre riguardo per l’impatto sull’ambiente e sull’assetto sociale, realizzando un Sistema di IA che possa contribuire ad uno sviluppo sostenibile. In particolare questo requisito si esplica in sotto requisiti quali:

-

- Sostenibilità e rispetto dell’ambiente : Il processo di sviluppo, distribuzione e utilizzo del Sistema di IA, dovrebbe essere valutato sulla base del fatto che si garantisca il più possibile il rispetto dell’ambiente ad esempio tramite un esame critico dell’uso delle risorse e del consumo energetico scegliendo le opzioni meno dannose e incoraggiando le misure che garantiscano la sua compatibilità ambientale.

- Impatto sociale : tenendo conto che un Sistema di IA può essere utilizzato per migliorare le condizioni sociali, ma possono parimenti contribuire al loro deterioramento, anche influendo sul benessere fisico e psichico delle persone, è necessario che tale sistema sia attentamente monitorato e valutato.

- Effetti sulle Istituzioni : occorrere valutare anche l’impatto sociale del Sistema di IA, tenendo conto dei suoi effetti sulle istituzioni, sulla democrazia e sulla società in generale

7) Responsabilità:

Collegato al principio della Equità. Occorre mettere in atto meccanismi che garantiscano l’accountability dei sistemi di IA e dei loro risultati, sia prima che dopo la loro attuazione. In particolare questo requisito si esplica in sotto requisiti quali:

-

- Verificabilità : comporta la possibilità di valutare algoritmi, dati e processi di progettazione del Sistema di IA. La valutazione da parte di revisori interni ed esterni e la disponibilità delle relazioni di tale valutazione può contribuire all’affidabilità della tecnologia

- Riduzione dei potenziali effetti negativi : È particolarmente importante per tutti coloro che sono direttamente o indirettamente interessati ad identificare, valutare, riferire e ridurre al minimo i potenziali effetti negativi del Sistema di IA. Tali valutazioni devono essere proporzionate al rischio posto dai sistemi di IA

- Gestione dei Compromessi : Nell’attuazione dei requisiti summenzionati possono insorgere tensioni tra i requisiti stessi, il che può condurre a inevitabili compromessi che dovrebbero essere affrontati in modo razionale e metodologico nell’ambito dello stato dell’arte

- Possibilità di ricorsi : Si dovrebbero prevedere meccanismi accessibili e adeguati di ricorso in caso di effetti negativi o ingiusti del Sistema di IA. La certezza della possibilità di ricorso in caso di esiti avversi è fondamentale per garantire la fiducia. Si dovrebbe prestare particolare attenzione alle persone o ai gruppi vulnerabili

METODOLOGIE PER REALIZZARE UN SISTEMA DI IA AFFIDABILE

Per poter mettere in pratica i requisiti summenzionati è possibile utilizzare metodi sia tecnici sia non tecnici in tutte le fasi del ciclo di vita del Sistema di IA.

I metodi tecnici per garantire un Sistema di IA affidabile, che devono essere incorporati nelle fasi di progettazione, sviluppo e utilizzo di un Sistema di IA, possono comprendere:

Metodi Tecnici

- Architettura per un’IA affidabile : I requisiti per un’IA affidabile dovrebbero essere trasformati in procedure e/o vincoli di procedura fissati nell’architettura del Sistema di IA. A tal fine si potrebbe definire una “lista bianca” di regole (comportamenti o stati) che il sistema deve sempre seguire, una “lista nera” di restrizioni sui comportamenti o stati cui il sistema non deve mai trasgredire

- Etica e Stato di diritto fin dalla progettazione : La conformità ai requisiti deve essere implementata nella progettazione del sistema di IA. Spetta al fabbricante la responsabilità di individuare fin dall’inizio sia gli effetti dell’esecuzione del Sistema di IA sia le norme alle quali tale sistema dovrebbe attenersi per evitare effetti negativi

- Metodi esplicativi : Affinché un Sistema di IA sia affidabile, occorre essere in grado di capire perché si è comportato in un certo modo e perché ha fornito una data interpretazione. Per tale motivo la progettazione degli algoritmi dovrebbe essere il più possibile di tipo white box in modo che un progettista sia in grado di spiegare perché tale sistema sia arrivato ad una specifica decisione

- Prova e convalida : L’attività di prova e convalida del Sistema di IA dovrebbe essere svolta il prima possibile per assicurare che esso si comporti come previsto per l’intero ciclo di vita e soprattutto dopo la sua distribuzione ed utilizzo. Data la natura non deterministica dei sistemi di IA, i metodi di prova tradizionali non sono sufficienti, ma per verificare e convalidare l’elaborazione dei dati é necessario che la stabilità, la robustezza e il funzionamento del modello siano attentamente monitorati, sia durante l’addestramento sia durante il suo utilizzo, attraverso opportune metriche

Metodi non Tecnici

- Regolamentazione : Assicurarsi che il Sistema di IA sia realizzato in conformità alle leggi e regolamenti vigenti come ad esempio il GDPR per la gestione dei Dati Personali.

- Codici di Condotta : Un’organizzazione che si occupa di un sistema di IA dovrebbe documentare, attraverso una propria Politica aziendale dell’Intelligenza Artificiale, le modalità con cui intenda approcciarsi a questo strumento stabilendo livelli adeguati di determinati valori come: i diritti fondamentali, la trasparenza e la prevenzione dei danni

- Normalizzazione : I processi di Progettazione, Produzione e Commercializzazione (che possono fungere da Sistema di Gestione per la Qualità per i fabbricanti di applicazioni di AI) possono essere sviluppati in conformità di linee guida e standard quali ad esempio ISO IEC 24028-2020 : “Information technology Artificial intelligence : Overview of trustworthiness in Artificial Intelligence” e IEEE 7000-2021 –: “Standard Model Process for Addressing Ethical Concerns during System Design”

- Certificazione : E’ in fase di definizione l’iter per la certificazione di prodotti che si basano su piattaforme di IA. Infatti La Commissione europea ha presentato il 21 aprile 2021 la proposta di un Regolamento sulla Intelligenza Artificiale che avrà lo scopo di istituire un quadro di riferimento legale volto a normare il mercato dell’Unione Europea dell’IA. Tale regolamento aprirà la strada se non ad una sorta di Marcatura CE dei Sistemi di IA, almeno ad una certificazione di conformità delle applicazioni IA

- Responsabilità : Le organizzazioni dovrebbero istituire quadri di governance, sia interni che esterni, garantendo un livello di responsabilità per le dimensioni etiche delle decisioni associate allo sviluppo, alla distribuzione e all’utilizzo del Sistema di IA. Ciò può includere, ad esempio, la nomina di una persona responsabile delle questioni etiche relative all’Intelligenza Artificiale o di un comitato/panel etico interno/esterno che abbia il compito, tra gli altri, di prestare sorveglianza e fornire consulenza

- Istruzione e sensibilizzazione : Un Sistema di IA affidabile incoraggia la partecipazione informata di tutti i suoi portatori di interessi. La comunicazione, l’istruzione e la formazione svolgono un ruolo importante, sia nel rendere ampiamente noti i possibili effetti dei sistemi di IA, sia per informare le persone che possono contribuire a plasmare lo sviluppo sociale

- Partecipazione dei portatori di interessi : Coinvolgere gli Stakeholders per discutere l’uso del Sistema di IA e l’analisi dei dati attraverso una sorta di Panel Group che dovrebbe essere composto da vari membri, quali giuristi, tecnici, esperti di etica, rappresentanti dei consumatori e lavoratori ecc.

- Diversità e team di progettazione inclusivi : Poiché i sistemi di IA svolgono svariati compiti autonomamente, è essenziale che il team che progetta, sviluppa, prova, esegue la manutenzione, distribuisce e/o acquista questi sistemi rifletta la diversità degli utenti e della società in generale. Per tale motivo sarebbe utile che tali team siano diversificati sia in termini di genere, cultura, età, che in termini di esperienze professionali e competenze. Indicazioni chiave

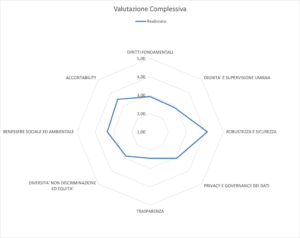

VALUTAZIONE DELL’ AFFIDABILITÀ DI UN SISTEMA DI IA

Vi sono vari metodi per verificare il grado di affidabilità di un Sistema di IA. Una metodologia è quella di effettuare degli assesment che verificano, attraverso delle opportune checklist possibilmente realizzate da un panel di esperti, la conformità dei Sistemi IA ai requisiti che abbiamo elencato in questo documento

Un’altra metodologia è quella di utilizzare Modelli di Autovalutazione sulla falsa riga delle indicazioni del Cybersecurity Framework (CSF )del National Institute of Standards and Technology (NIST) che è un framework costituito da standard, linee guida e procedure consigliate per gestire i rischi correlati alla cybersecurity.

Tali Modelli, che sono implementati in specifici tool, si basano sulle sette categorie che rappresentano i requisiti di affidabilità di un Sistema di AI e dei loro sotto-requisiti

Il modello produce poi dei grafici riassuntivi della fotografia dell’organizzazione come quello riportato nell’ esempio.

Fonte ICT Security “Modello di autovalutazione relativo ad un sistema di Intelligenza Artificiale” pubblicato il 19 ottobre 2020

GRAZIE PER L’ATTENZIONE

NOTA DELL’AUTORE

Volevo porre un particolare ringraziamento all’amico Ing. Edoardo Chiesa il cui contributo nella stesura e nella correzione di questo articolo è stato fondamentale. Grazie EDO

Commenti recenti